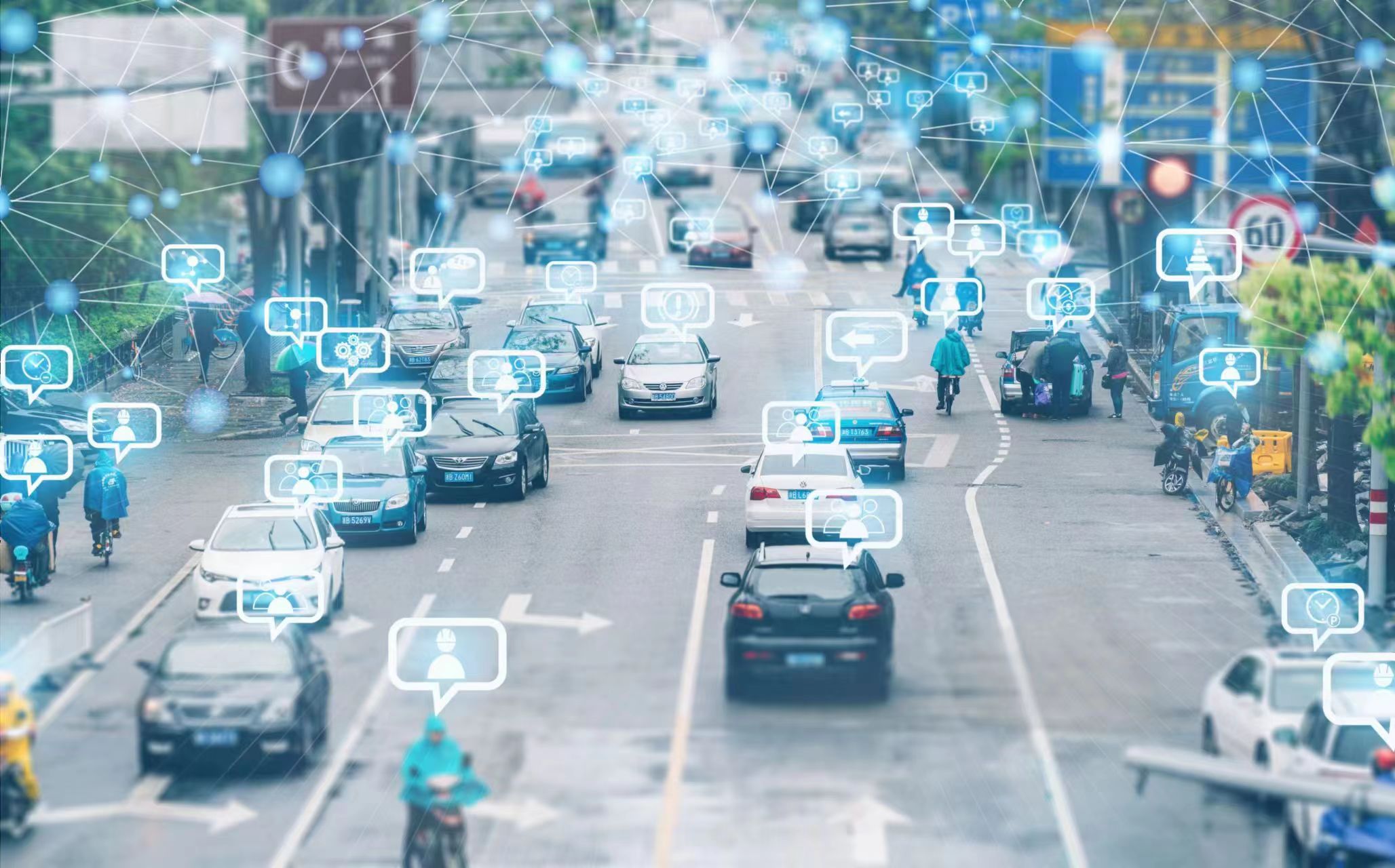

自動駕駛的系統分為感知、決策和執行三大模塊,車內外的數據流是以感知為始,車輛的執行為終,整個系統和計算機系統類似輸入信息——計算處理——輸出結果。感知模塊作為自動駕駛系統的初始條件輸入,一定程度上決定著自動駕駛系統的下限,同樣,機器視覺從感知到認知的進化過程中,自動駕駛將會是一個重要的應用場景,汽車的智能化也是機器智能的子領域。人類對機器智能的探索過程也是人類不斷對物理世界開展計算的過程,1950年英國計算機科學家圖靈提出的圖靈測試,通過模擬一個智能對話來判斷機器是否具備人類水平的智能,本質上也是對數字計算能力的邊界探索。自動駕駛也是汽車周圍環境的數字計算處理,也是不斷逼近模擬真實物理世界的過程。

從人類科學的發展歷程中可以發現,所有新技術新產品的基礎都是物理方法和數學理論的支撐。自動駕駛是在計算機體系的大廈上建造的自動駕駛系統具備甚至超越人類的駕駛水平,目標的參照物是以人為核心,實現智能化產品的需求管理、設計方法、交互邏輯。所以,自動駕駛系統和人的生物系統具有相似性,這種相似性主要體現在兩個層面。

第一個層面是系統層面。從生物學的角度看,人的眼睛是人類器官中最重要的器官,居五官之首。視覺在人們認識客觀世界的過程中起到極其重要的作用,通常外界環境感知信息90%是由視覺完成。同理在自動駕駛系統中,環境感知中的視覺扮演著十分重要的角色,尤其是在特斯拉汽車的純視覺自動駕駛系統的影響和產品落地成本壓力之下,單傳感器的視覺在自動駕駛系統中的重要性更加明顯。

自動駕駛的技術探索也是發起在計算機視覺領域,在上世紀70年代自動駕駛技術在學術界的探索期,視覺算法主要是基于簡單的規則和啟發式方法來處理和識別簡單的形狀和模式;90年代,計算機在處理速度和存儲技術方面性能提高,計算機視覺系統應用范圍進一步擴大,自動駕駛技術的探索開始萌芽;2010年左右,深度學習技術在計算機視覺領域廣泛發展,神經網絡算法引入自動駕駛視覺感知算法之中,自動駕駛系統的感知效果有了質的提升,與此同時自動駕駛成為科技領域的新風口,資本和創業者涌入自動駕駛賽道。可以說自動駕駛技術的進步也是計算機視覺技術發展的歷程,視覺能否實現無人駕駛有待驗證,但是自動駕駛一定是需要視覺技術的支撐;

第二個層面是更深一點的視覺技術層面。在對物理世界的感知層面,相比圖靈機時代的符號主義,以聯結主義時代通過模仿動物神經網絡行為特征,進行分布式并行信息處理的算法模型進一步拉近了數字世界和物理世界的距離,首先是神經網絡中感知機所用的元模型最早是在1943年提出的M-P模型,該模型將輸入信號進行加權平均運算,若超過某一個閾值則向后傳遞信號否則被抑制,有點類似半導體的二極管原理很通俗易懂,但是實現的方式和效果卻需要一定的工程能力;

其次模型訓練的理論依據是在1949年提出的赫布學習規則。所以說,人類對智能的探索從未停止過,1956年達特茅斯會議首次提出人工智能的概念發展至今,隨著數據和算力的提升,人工智能又迎來一次躍遷。在計算機視覺感知領域以神經網絡為主干可以劃分為小模型時期和當下流行的大模型時期,小模型的代表是深度神經網絡、卷積神經網絡、循環神經網絡等等,大模型的代表是Transformer架構。

從小模型到大模型并不是理論上的顛覆和切換,首先是視覺算法技術的延續,正是這種延續性和相似性讓視覺感知的商業化范圍擴大,間接的影響自動駕駛乃至智能化的技術發展;其次是用物理的思維認知數字世界。從神經網絡的變化過程中可以看出這一趨勢,深度神經網絡是多層感知機網絡,具有三個基本類型的層,輸入層、隱藏層和輸出層,不同層之間的感知機是全連接,逐層單向傳遞信號,本質上是對像素點的一一對比學習。在自動駕駛感知中,輸入層得到的數據是圖像,而圖像是一個多維的數據,在識別的過程中需要設置大量輸入神經元及多個隱藏層,顯然這種神經網絡模型的參數量很大,結果就是訓練難度增大并且算力要求很高。

在物理學上,伽利略經典的兩個鐵球同時落地的實驗標志著科學的新紀元,物理方法的核心是尋找事物所遵守的基本法則和原則,例如無論圓的半徑多大,圓周率是不變的、伽利略推翻亞里士多德的理論,證明物體下落的快慢和物體的重量無關,例如測量國界線的長度,即使在歐幾里得幾何圖形中也無法用米尺測量,但是可以在地圖中使用比例尺和測量單位的手段獲得界限的長度。在這個過程中,物理世界和數字之間的邏輯關系是不變的,通過事物的特征獲取了事物的全貌。這種思路在視覺感知領域的應用正如一張圖片中人臉的識別,并不需要對每個像素點進行一一對比學習,而是先搜索臉部輪廓以及五官及其他特征,當這些特征同時出現時,就可以判定圖片中是人臉,這種思路在算法中就是卷積神經網絡,本質上是在數據輸入深度神經網絡之前進行數據的特征提取后的降維,從而提高神經網絡的運行效率,降低對算力的要求。

然而在卷積神經網絡對數據進行特征提取降維之后會丟失一些有價值的信息,忽略整體和局部之間的關聯性,這種關聯性除了空間還有時間序列的關聯。例如再回到人臉識別的例子中,神經網絡提取了臉部輪廓和五官的特征之后就可以判定是人臉,但是在一張圖片中,如果五官和臉部輪廓是分離的,按照卷積神經網絡仍然有概率將圖片識別為人臉。第二例子,在自動駕駛中,視覺感知需要完成目標的跟蹤以及盲區的預測等任務,這就需要在神經網絡中具備處理時間序列的信息。這就是在傳統的深度神經網絡中的隱藏層中引入循環,也就是在每一個隱藏層上的感知機都有上一時刻的隱藏層上而所有記憶連接,在輸出層的體現除了輸出當前時刻的輸入信息以外,又加入了之前某時刻的輸出相關。這樣一來,在感知算法層面可以實現時間和空間的計算和擴展,物理中的體現即為維度的處理過程。循環神經網絡的弊端在于硬件需要更大的緩存同時整個網絡對數據的并行處理能力下降從而限制計算效率。

在物理領域,一般機械效率的計算是輸出功與輸入功的百分比,做功的多少也是和時間和空間緊密相關。而在算法領域,算法的效率分析主要分為兩類,第一類是時間效率,也就是時間復雜度,主要是衡量算法的運行速度;第二種是空間效率,也就是空間復雜度,主要衡量運行算法所需要的額外空間,典型的例如硬件存儲。無論是物理還是數字算法都在時間和空間的維度進行優化,提升系統的運轉效率,同時這兩個維度也是一切系統和產品設計最本源的出發點。在感知算法層面,空間的體現就是泛化性,時間的體現就是并行計算效率。小模型的時代,神經網絡只能處理標準過的物體進行相似性比對,通過不斷地對比學習完成識別任務,存在存儲時間長度有限以及順序依賴的問題。

2017年谷歌發表論文提出Transformer網絡架構,其基本思想是假設一個有邏輯的序列,關鍵是為每一個元素(token)找到其他元素(token)的關系權重。Transformer網絡架構最早是在自然語言處理領域大殺四方,自然語言處理是一個序列任務,Transformer網絡架構處理自然語言處理中有天然的優勢。2020年,Vision transformer網絡將圖片按序列切成小片后再輸入到transformer模型架構中,標志著transformer正式進入計算機視覺感知領域。從語言語音處理到視覺圖像處理,也是視覺感知技術從規則經驗到數據驅動的過程,語言處理的本質是信號的處理,Transformer網絡架構的應用將語言語音和視覺圖像集中到了統一的基礎框架之下,再次凸顯出物理方法在數字算法領域的應用。Transformer網絡架構引入了注意力機制,只對重要的信息關注而非全部的信息,在時間性方面具有更高的并行計算效率,在空間性能方面具有更強的泛化性。

2021年特斯拉汽車在AI day上展示了Transformer網絡架構在自動駕駛領域的應用,預示著自動駕駛視覺感知技術正式進入大模型時代。

自然語言處理和圖像識別二者都可以統一在信息論的技術框架之下,而自然語言是一個時間序列的輸入,而圖像識別會涉及到維度空間的變化,理解維度的變化也就是認知世界坐標的變化。BEV鳥瞰圖是將三維視角進行降維,以“上帝視角”描述感知物理世界的坐標,所以不僅僅是應用在純視覺、也可以是多源傳感器融合甚至在車路協同中。也就是說,BEV+Transformer網絡架構的大模型在一定程度上可以解決自動駕駛感知的時間性和空間性的問題,感知效果將會有質的提升,但是是否會成為終極的自動駕駛感知方案仍然需要產品和技術發展的驗證。

從特斯拉汽車到國內自動駕駛相關的企業的策略中可以看出,自動駕駛的下一個競爭場景是城市輔助駕駛,相比以前高速場景,城市場景首先是出現頻率更高,用戶更加剛需;其次城市場景面臨的長尾問題更加復雜,更加能體現技術的領先性;最后城市場景更加偏向C端市場,這就意味著對自動駕駛系統的成本約束更大。BEV+Transformer網絡架構的大模型現階段可以在底層技術上提高算法效率同時增加了算法的可擴展性,下一步需要考慮的就是成本問題,在自動駕駛系統上做減法。

第一階段、降低高精度地圖的輸入權重。首先有個大前提,所有的智能體一定是需要地圖的,地圖是理解物理世界的空間分布、相關關系和發展趨勢的重要手段。車載高精度地圖數據規模巨大,制圖和更新耗費資源較多,地圖的精度和系統的成本出現博弈。在BEV空間坐標下,自動駕駛車輛通過將不同視角的視覺圖像統一轉換到上帝視角,相當于實時生成地圖信息,為決策規劃提供道路拓撲信息。所以,行業內“輕地圖、重感知”成為自動駕駛當前的主流方案。例如小鵬汽車,增加車載算力,利用多相機和雷達數據融合,直接輸出BEV下交通參與者的靜態和動態信息,一定程度上具備了實時生成地圖的能力。這一點小鵬汽車、毫末智行等國內眾多的視覺方案和特斯拉是相似的。解決一個問題,新的問題又出現了,純視覺方案的******的問題在于在訓練集中沒有出現過的物體,系統是無法識別的,也就意味著現階段的純視覺技術一定會有約束性,長尾問題一直存在。

第二階段、占用網絡,將視覺識別體素化。2022年特斯拉汽車在AI day上展示了Occupancy Network新一代的視覺感知技術,先將三維空間劃分為體素(小立方體),再去預測每個體素是被占用還是空閑,通過體素的概率值預測可行駛區域。BEV是一個2D的圖像空間,而占用網絡是升級為3D的處理空間,這樣就可以通過視覺技術彌補部分激光雷達的作用。并且在特斯拉汽車在HW4.0中預留了4D毫米波雷達接口,這是彌補視覺算法中識別物的高度信息。

第三階段、基于大模型的端到端自動駕駛模型。端到端的自動駕駛系統本質目標是建立一個驅動模型,以時間為序列將輸入信息映射到控制執行側。在自動駕駛行業初期,2016年英偉達發表論文《End to End Learning for Self-driving Cars 》介紹了實現車道保持功能的端到端模型。一時間端到端的方法成就了眾多的自動駕駛demo車,然而面對嵌入式量產成本和可解釋性的要求,自動駕駛的端到端方法逐漸被冷落,這也是眾多自動駕駛創業公司面對量產出現的根本性的難題。

大模型在視覺感知領域的興起又一次將端到端的方法引入到自動駕駛行業。2023年CVPR******論文《Planning-oriented Autonomous Driving》(以路徑規劃為導向的自動駕駛),論文首次提出感知決策一體化的自動駕駛通用大模型UniAD,開創了以全局任務為目標的自動駕駛大模型架構先河,提高了自動駕駛系統的擴展性。在今年CVPR的workshop中,特斯拉汽車的感知負責人也發表演講,介紹了通過BEV網絡進行特征提取后建立的基礎模型——World Model,然后可以通過微調來實現下游任務,這種方法和語言大模型中的預訓練+微調的范式很像,以World Model作為自動駕駛基礎模型下游任務包括占用、路面、物體、車道線、紅綠燈。雖然特斯拉汽車并沒有明確押注大模型的端到端自動駕駛方向,但是可以肯定的是他們一定也在這方面有探索嘗試,具體就看今年的AIday是否會有驚喜。

理想汽車在6月份的家庭科技日發布自動駕駛技術進展,采用BEV大模型,實時感知和理解環境中的道路結構信息,針對復雜路況、使用自研的神經先驗網絡提前進行路口神經先驗網絡特征的提取和存儲,再與車端感知大模型融合得到感知結果。,針對信號燈識別,訓練了端到端的信號燈意圖網絡,用大模型可以實現端到端信號燈意圖識別。

從生物學的角度來看,端到端的方法更類似人類的信息處理過程。然而端到端需要大量的數據訓練并且存在不可解釋性。這一點和當年飛機的出現有點相似,鳥飛派和空氣動力學派最終勝出的是空氣動力學派。按照這種思路,端到端的方法將會是一條斷頭路,但是在AI時代,一切基礎原理都有可能被重構,所以未來自動駕駛是基于大模型的端到端還是從場景到駕駛行為的映射不好預測,唯一可以確定的就是大模型時代端到端方法也是一條探索自動駕駛的新途徑。

無論是自動駕駛產品還是底層算法,人類的目標始終都是通過數字無限逼近真實物理世界,在科學的范疇之內,物理世界理論上是可以測量計算的,例如前面提到人的視覺可以處理90%的信息。然而人類的肉眼只能看到5%的世界,例如電磁波,超聲波這些視覺是無法感知到,所以作為一個機器智能體,應該是在時間維度和空間維度領先于人類,而不是和人類持平。作者:

010-56381676

010-56381676 customer-service@zttledu.com

customer-service@zttledu.com